Faszinierend: ein Film von 1982, in dem Leute wie Ken Thompson, Dennis Ritchie und Brian Kernighan („Wer hat’s erfunden?“  ) das Betriebssystem Unix beschreiben — und wenn man mal von den Rechnern absieht ist alles so aktuell wie Heute. Das sind mal haltbare Ideen gewesen, seinerzeit!

) das Betriebssystem Unix beschreiben — und wenn man mal von den Rechnern absieht ist alles so aktuell wie Heute. Das sind mal haltbare Ideen gewesen, seinerzeit!

Kategorie: IT

Technikbezogene Themen

Speicherverbrauch von Firefox-Extensions

Der gute alte Firefox ist immer noch der Browser meiner Wahl. Und er wird immer besser. Einziger Haken ist nach wie vor, dass er sich bisweilen doch ziemlich viel Hauptspeicher genehmigt. Man fragt sich was er wohl damit anstellt, und bis jetzt musste zumindest ich an der Stelle mit Vermutungen leben.

Oft ist es nicht der Firefox selbst, der den Speicher auffrisst. Auch Extensions können sich gerne mal ein großes Stück vom Kuchen abzwacken, und man schiebt es dann erstmal auf den Browser.

Gerade habe ich einen Weg kennengelernt, wie man sich seit Version 24 die Interna ansehen kann:

- In der URL-Leiste about:support eingeben. Hier sind unter anderem alle Erweiterungen aufgelistet.

- Man merke sich die ID der verdächtigen Extension (rechte Spalte).

- Wieder per URL-Leiste — idealerweise in einem zweiten Tab — about:memory ansurfen. Hier unter „Show memory reports“ mit „Measure“ eine Messung tätigen.

- Mit etwas Glück kann man direkt nach der gemerkten ID suchen (Strg-F). Klappt das nicht, sucht man nach „add-ons“ und expandiert hier so lange die Zweige bis man die gesuchte ID findet.

Gleich direkt mal sehen ob ich hier was überdimensional großes finde…

NAS unter Proxmox: NAS4Free, OpenMediaVault oder Openfiler?

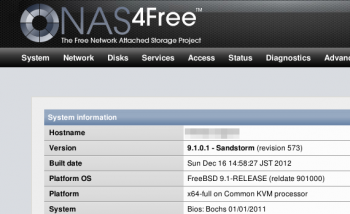

Vollvirtualisiert wird mit KVM, das hat es mir ermöglicht ein NAS4Free als Fileserver einzusetzen. Das basiert auf FreeBSD, es hat eine nette Oberfläche und ist alles in allem echt unkompliziert. Ein Killer-Feature ist die native Unterstützung von ZFS. Ausprobieren musste ich das, obwohl mir klar war dass das auf meiner bescheidenen Hardware wenig Spaß machen würde. Und richtig genug: spätestens mit ZFS waren Zugriffe auf Netzlaufwerke unerträglich langsam.

Ich will nichts gegen ZFS sagen. Das ist eine coole Technik, aber definitiv nicht für meine Umgebung gedacht. In einer virtuellen Maschine mit virtuellen Festplatten und nur sehr wenig Hauptspeicher kann es seine Leistung beim besten Willen nicht ausspielen. Schade. Wenn ich mal einen Fileserver auf echter Hardware bauen will komme ich gerne wieder drauf zurück. Und auf NAS4Free.

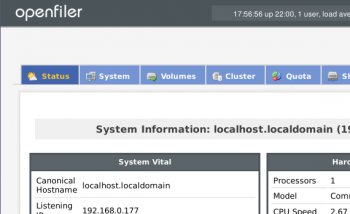

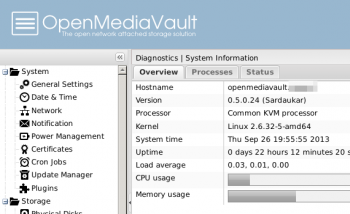

So musste ich mich erstmal nach einer Alternative umsehen. Dabei bin ich ziemlich schnell wieder auf zwei Projekte gestoßen von denen ich schon öfter gelesen hatte: OpenMediaVault und Openfiler. Bevor ich mich aber dazu entschließe alles umzuwerfen muss erstmal getestet werden ob die in meiner Situation besser performen würden. Also habe ich beide mal testweise installiert und ein paar Versuche unternommen.

Installiert hatte ich von diesen ISOs:- NAS4Free-x64-LiveCD-9.1.0.1.573.iso

- openmediavault_0.5.0.24_amd64.iso

- openfileresa-2.99.1-x86_64-disc1.iso

Aber erstmal die Rahmenbedingungen: in dem Server steckt ein Intel Core2Duo E6750, 8GB RAM, zwei SATA-Platten im Software-RAID1 und ein 100MBit-Netzwerk. Den virtuellen Maschinen habe ich jeweils 512MB RAM gegeben, das muss für so einen kleinen Einsatz genug sein finde ich. Systemplatten hatte ich jeweils in 1GB vorgesehen, aber an der Stelle hat Openfiler schon nicht mitgespielt: unter 10GB lässt der sich nicht installieren. Ganz schön viel für ein One-Trick-Pony. Belegt waren nach der Installation 1,7GB. OpenMediaVault hat sich 658MB genommen, NAS4Free war sogar mit 274MB zufrieden.

Mein Anspruch ist, dass ich der virtuellen Maschine bei Bedarf Festplatten nachschieben kann, die dann in einen logischen Verbund — LVM oder ZFS — stecke und darauf flexibel Volumes anlegen kann, deren Größe ich dann den Anforderungen anpassen kann. Redundanz brauche ich hier nicht, da die Platten im Hostsystem schon als RAID1 laufen.

Voll und ganz erfüllt den Anspruch ein ZFS auf NAS4Free. Nur ist das halt auf meiner Hardware zu langsam. Nur mal testweise habe ich ein JBOD auf NAS4Free angelegt. Da könnte ich zwar Platten nachschieben, dafür habe ich aber nicht herausgefunden wie ich einzelne Volumes anlegen kann (das was unter Linux LVM macht). Ob das überhaupt geht würde mich schon noch interessieren, aber schneller wuerde es dadurch wohl auch nicht mehr.Auf den beiden Linux-Systemen habe ich jeweils ein LVM aus zwei 10GB-Platten angelegt — bei OpenMediaVault mit einem nachinstallierten Plugin — und darin ein ext4-Volume mit 12GB erzeugt auf dem ich getestet habe. Openfiler unterstützt auch schon btrfs, also habe ich das auch mal ausprobiert.

Drei Tests habe ich auf allen diesen Plattformen durchgeführt: erst habe ich ein ISO-File per SCP auf die Laufwerke übertragen (ubuntu-12.10-desktop-amd64.iso, etwa 800MB), dann jeweils an der Shell lokal auf den NAS-Systemen ein tar-File dieses ISOs angelegt (time tar cf test.tar ubuntu*.iso). Zusätzlich habe ich die beiden Tests lokal auf dem Proxmox durchgeführt, nur um ein Gefühl dafür zu bekommen was die Physik hergeben würde. Hier die Zahlen:

| ISO per SCP kopieren | ISO in tar packen (lokal) | |

|---|---|---|

| Lokal, ohne NAS | 40.2MB/s | 17s |

| NAS4Free / ZFS | 3.7MB/s | 247s |

| NAS4Free / JBOD | 6.4MB/s | 94s |

| OpenMediaVault / LVM / ext4 | 13.5MB/s | 26s |

| Openfiler / LVM / ext4 | 17.7MB/s | 77s |

| Openfiler / LVM / btrfs | 15.9MB/s | 50s |

Nochmal der Hinweis: das sind nur Stichproben. Ich habe alle Tests nur einmal durchgeführt, und man wird garantiert andere Werte bekommen wenn man die NAS-Systeme nicht in einer virtuellen Maschine installiert sondern auf richtigem Blech. Mir persönlich reichen die Zahlen als Anhaltspunkte. YMMV.

So gerne ich auch bei NAS4Free bleiben würde: ich denke mein neuer Fileserver wird ein OpenMediaVault werden. Auf meiner schmalen und noch dazu virtualisierten Hardware kann NAS4Free sich leider nicht wirklich entfalten. Die Zahlen sprechen hier einfach für Linux. Und OpenMediaVault macht nicht nur beim IO einen guten Eindruck, auch der schmale Fußabdruck bei der Installation ist sympathisch. Oh, und unten drunter liegt ein Debian, das befindet sich hier in guter Gesellschaft. Nur auf btrfs muss ich leider noch verzichten. Das gibt es erst wenn OMV ein Update auf Squeeze vornimmt. Aber bis dahin habe ich schonmal was…

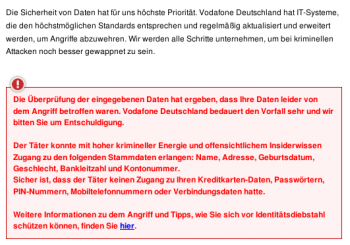

Vodafone: mich hat’s erwischt!

Wer testen will ob er auch betroffen ist kann das online checken, man gibt auf der Seite nur Kontonummer und Bankleitzahl ein. Die Übertragung passiert dann sicher per SSL…

OpenVMS ist nicht mehr

Schade. VMS ist sicher eines der interessanteren Betriebssysteme. Habe ich leider nie persönlich kennenlernen dürfen, aber ich wäre mit Eifer dabei gewesen. Jetzt gehen die Chancen gegen Null, das nochmal zu Gesicht zu bekommen: HP hat die Entwicklung eingestellt.

eBay: technische Daten

Ich weiss nicht seit wann, aber eBay veröffentlicht unter dem Namen ‚Digital Service Efficiency‚ einige technische Daten aus deren Rechenzentren. Erstaunlich freizügig, und erstaunlich tiefgehend. Sollten sich alle ein Beispiel dran nehmen die große EDV machen, finde ich.

Telekom-Drosselung: Heise hat meine Meinung

Am Montag habe ich mich — zugegebenermaßen etwas flapsig — zu dem Thema der Volumenbeschränkung bei der Telekom geäußert. Das Thema ist aber zu ernst um nur drüber zu lachen, und bei Heise lese ich gerade einen Kommentar der ziemlich exakt meine Meinung dazu wiedergibt. Lesen und verstehen, bitte. Danke.

Update-Dschungel: apt-get upgrade?

Interessant: vor einiger Zeit habe ich mit einem damaligen Kollegen darüber gesprochen dass ich es unzumutbar kompliziert finde, ein Windows-System aktuell zu halten. Dabei bedeutet ‚aktuell‘ nicht nur dass man die neuesten Features nutzen kann, sondern insbesondere auch dass Sicherheitslöcher — die es heutzutage sogar in MP3-Abspielern und PDF-Betrachtern geben kann — gestopft werden.

Leider erwähnt es der Artikel nicht den Heise Gestern zu dem Thema veröffentlicht hat, daher schreibe ich es nochmal (falls der ehemalige Kollege oder sonstwer aus der Zielgruppe mitliest): Wo Windows-Anwender im Schnitt an 25 Stellen (die Zahl nennt der Artikel, die stammt offenbar von Secunia) nach Updates suchen müssen greifen Linux-Benutzer üblicherweise nur auf einem einzigen Weg auf ihre Software-Repositories zu. Debian-Benutzer geben beispielsweise nur apt-get update && apt-get upgrade ein und können sich sicher sein die letzten Pakete installiert zu haben die ihre Distribution ihnen bietet. Fertig. Grafische Benutzeroberflächen, insbesondere auf Mainstream-Systemen wie Ubuntu, bringen die Funktionalität grafisch. Da muss man weder selbst an den Check denken, noch das Kommando für das Update auswendig gelernt haben.

Insbesondere bei Sicherheitsrelevanten Updates sind eigentlich alle gängigen Linuxe ziemlich schnell. Ich persönlich habe ein gutes Gefühl bei der Sache.

Zwei Einwände hatte der Kollege seinerzeit noch:

- Was ist mit Programmen die nicht von der Distribution gestellt werden? — Brot- und Butterprogramme wie Webbrowser, Office-Pakete oder Java-Laufzeitumgebungen bieten alle Distributionen. Braucht man eine spezielle Software findet man mit etwas Glück ein spezialisiertes Repository das man einfach einbinden kann. Gibt es auch das nicht bleibt einem wirklich nur die manuelle Installation. In dem Fall muss man aber nur ein einzelnes Programm manuell aktuell halten. Nicht alle (OK, fast alle). Wenn man mehrere Rechner versorgen will, beispielsweise in Unternehmen, spricht aber auch nichts dagegen sich ein eigenes Repo anzulegen. Schwer ist das nicht.

- Datenschutz? Ist Dir egal dass $DISTRIBUTOR weiß was Du alles installiert hast? — Ja. Weil ich dem Hersteller meines Betriebssystems traue, sonst würde ich es nicht nutzen. Aber selbst wenn man das anders sieht: so ein Repository kann man auch komplett oder teilweise spiegeln, insbesondere in Unternehmen kann das schon allein deshalb sinnvoll sein damit nicht alle Pakete n mal übertragen werden müssen. Dementsprechend hat man in der Regel auch die Auswahl zwischen mehreren Repositories im Netz. Da kann man sich dann überlegen wem man das Vertrauen schenken möchte.

Alles in allem bleibe ich bei dem was ich damals schon gesagt habe: ständig auf der Jagd nach Updates zu sein wäre mir zu stressig. Und das würde ich insbesondere nicht-computeraffinen Benutzern nicht zumuten wollen. Denkt daran wenn Eure Eltern von Euch einen Computer eingerichtet haben wollen!

Schön finde ich übrigens, dass Heise in dem Artikel auf XKCD linkt.

Die Telekom-Drossel: bitte für alle Tarife

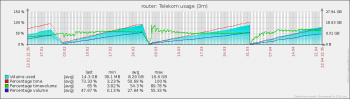

Bis Januar hatte ich im UMTS-Netz eine Drossel nach 10GB. Seit LTE kann ich ungestraft 30GB übertragen. Technisch gibt das LTE-Netz auf dem Land ’nur‘ 50MBit her (ja, ich jammere auch nicht mehr), ich habe aber den 100MBit-Vertrag gemacht da hier das Volumen größer ist.

Jetzt ist in der Ankündigung die Rede von 75GB bei 16MBit im Festnetz, das ist das kleinste Paket. Bei den 50MBit die ich technisch erreichen könnte wären es 200GB, bei den 100MBit für die ich bezahle sogar 300GB — locker eine Verzehnfachung.

Kriege ich die dann auch?

(Wirklich verbraucht habe ich in der LTE-Zeit übrigens nie mehr als monatlich 16,6GB, und davon gehen allein etwa acht auf das Konto von Zabbix (ja, das könnte man volumensparender installieren — ist dann aber nicht mehr so cool für mich.  ))

))

Gummischlauch-Kryptoanalyse

Das Wort Rubber-hose cryptanalysis habe ich in Chaosradio 186 aufgeschnappt, es ging um elektronische Schließsysteme:

Rubber-hose cryptanalysis (übersetzt Gummischlauch-Kryptoanalyse) ist ein Euphemismus, mit dem die Verwendung von Folter mit der Absicht, eine Person zur Herausgabe eines Kennworts oder Entschlüsselungsschlüssels zu bringen, bezeichnet wird. Obwohl sich der Ausdruck selbst ursprünglich von einer Foltermethode ableitet, bei der jemandem mit einem Gummischlauch wiederholt auf die Fußsohlen geschlagen wird, steht er hier stellvertretend für alle Arten möglicher Foltermethoden.